Radar en video: een interessante combo voor sensorfusie

Het vermogen van auto's om snel en accuraat andere weggebruikers en obstakels te detecteren, speelt een belangrijke rol bij het terugdringen van het aantal verkeersongevallen. Geen enkele sensor kan dat echter op zijn eentje.

Camera's werken bijvoorbeeld minder goed 's nachts of wanneer de zon hen verblindt; en radarsignalen worden gestoord door reflecterende metalen voorwerpen. Maar wanneer we beide technologieën combineren, versterken ze elkaar. We spreken dan van radar-video sensorfusie.

Dankzij radar-video sensorfusie kan een verbeterd 3D-model van de omgeving rond een voertuig worden gecreëerd. Dat is noodzakelijk om de onderliggende artificiële intelligentie toe te laten gedetecteerde objecten te classificeren in categorieën – zoals auto's, voetgangers, fietsers of gebouwen. Op basis van die informatie kunnen rijhulpsystemen op hun beurt intelligente beslissingen nemen om ongevallen te vermijden.

De EU heeft de ambitie uitgesproken om – tegen 2050 – het aantal dodelijke ongevallen op de Europese wegen terug te dringen tot nul. Benieuwd hoe dat precies in elkaar zit, en welke rol daarbij is weggelegd voor bedrijven zoals Bosch, Infineon en NXP? Je komt er alles over te weten tijdens het automotivepanel op Future Summits 2022.

Zwakke weggebruikers nauwkeuriger én sneller opmerken

Er bestaan verschillende manieren om aan radar-video sensorfusie te doen. Bij de meest courante fusiesystemen verwerken de sensoren de data die ze ontvangen onafhankelijk van elkaar. Hun gegevens worden gecombineerd op het niveau van ‘beslissingen’: waar zien de sensoren obstakels? Het nadeel daarvan is dat elke sensor op zijn eentje moet beslissen wat belangrijk is, waardoor objecten soms gemist worden.

Anderzijds kan je een systeem ontwikkelen dat alle data doorstuurt naar een centrale computer, waar die dan samen verwerkt worden. Maar dat is erg complex, want zo’n systeem vereist veel rekenkracht én snelle dataverbindingen.

Omdat geen van beide scenario’s ideaal is, hebben imec-onderzoekers aan de UGent een derde optie ontwikkeld: coöperatieve radar-video sensorfusie, waarbij sensoren informatie uitwisselen om elkaars detectievermogen te verbeteren.

Uit eerder onderzoek bleek al dat coöperatieve radar-video sensorfusie erin slaagt om voetgangers en fietsers 20% nauwkeuriger in kaart te brengen dan systemen die alleen gebruik maken van camera's

Automatische tonemapping: het beste van twee werelden

Ondanks de beschikbaarheid van nieuwe technologie-opties – zoals radar – blijft cameratechnologie een fundamentele bouwsteen van toekomstige rijhulpsystemen. Maar ook camera’s hebben hun beperkingen: wanneer het donker is, bijvoorbeeld, is hun toegevoegde waarde beperkt.

Dat kunnen we gedeeltelijk omzeilen door auto's uit te rusten met camera's met een hoog dynamisch bereik (HDR) die niet verblind worden bij grote verschillen tussen licht en donker. Omdat zij meer data genereren, zou de onderliggende artificiële intelligentie van de rijhulpsystemen echter overbelast kunnen raken.

Dankzij automatische tonemapping kunnen we het beste van beide werelden combineren: het zet HDR-video om naar beelden met een normaal dynamisch bereik, en een lager dataverbruik, zonder informatie weg te gooien die cruciaal is voor het rijhulpsysteem.

Data weggooien is niet (noodzakelijk) hetzelfde als informatie weggooien

Het roept uiteraard de vraag op welke data kunnen worden weggegooid zonder mensenlevens in gevaar te brengen.

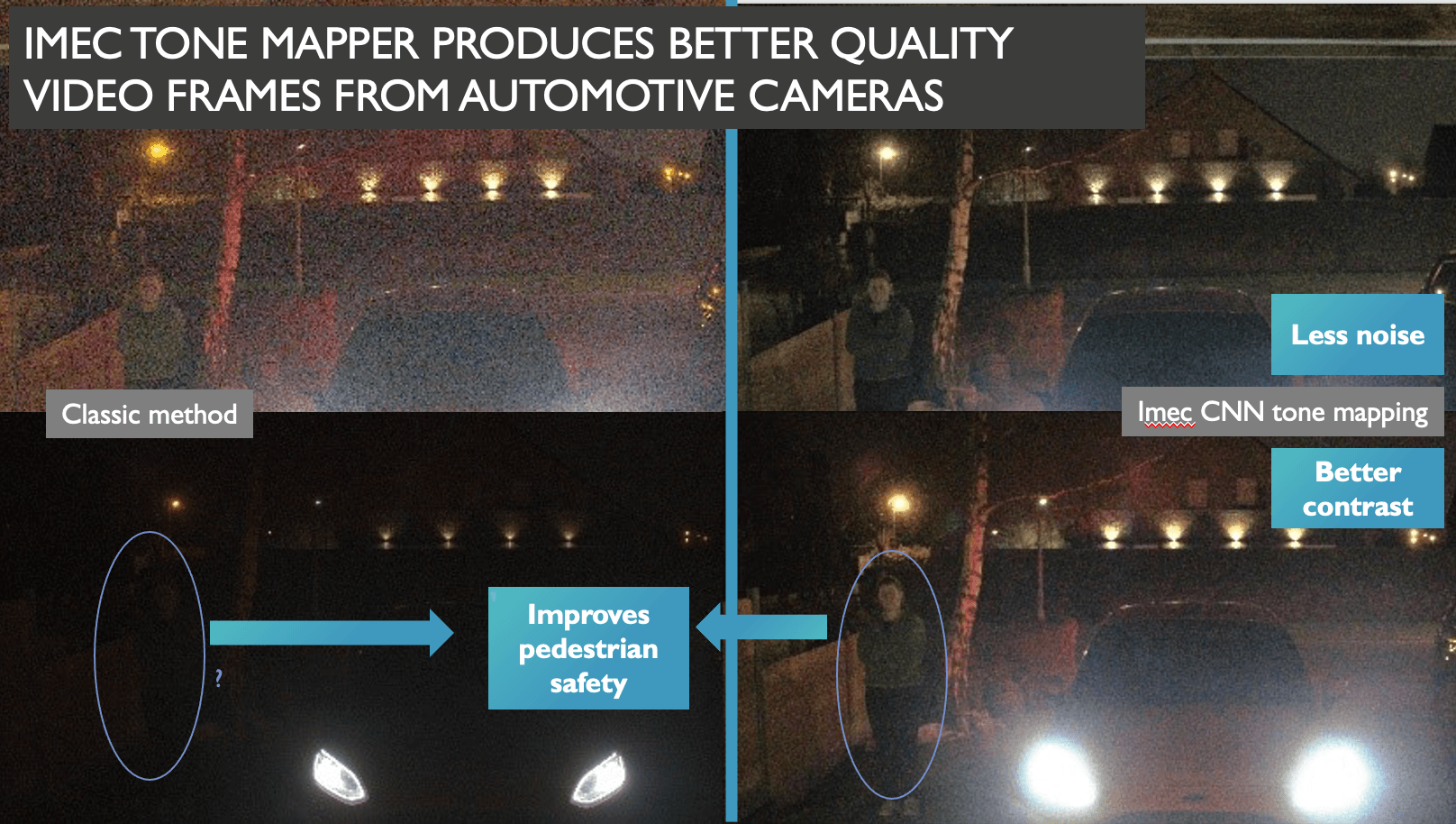

Figuur 1: De automatische tonemapping-aanpak van imec en UGent (rechts) vergeleken met bestaande tonemapping-software (links). Bron: imec.

Wat zien we? Het beeld linksonder toont – gedetailleerd – de koplampen van de auto, waardoor quasi niets anders zichtbaar is. In de opname rechtsonder zijn de details van die koplampen weliswaar verloren gegaan, maar is wel een voetganger te zien.

Daarin schuilt de kracht van automatische tonemapping. Bepaalde data worden weggegooid, maar de onderliggende artificiële intelligentie zorgt ervoor dat cruciale informatie over de aanwezigheid van kwetsbare weggebruikers behouden blijft.

Tien tot dertig procent nauwkeuriger

Louter visueel is de meerwaarde van automatische tonemapping dus duidelijk aantoonbaar. Maar de technologie van de imec en UGent-onderzoekers vertaalt zich ook in meetbare winsten.

Zo stelden ze vast dat het aantal onopgemerkte voetgangers daalt met 30% in vergelijking met het gebruik van een gewone camera. Ook de klassieke tonemapping wordt met 10% overtroffen. En in het verkeer zijn die procenten belangrijk: als elke auto een beetje meer ziet, kunnen een heel aantal ongevallen en bijna-ongevallen vermeden worden!

Dit artikel verscheen eerder als bijdrage in de EOS Wetenschap Special - Innovatie & Duurzaamheid.

Ingenieur Jan Aelterman is als onderzoeker verbonden aan IPI, een imec-onderzoeksgroep aan de UGent die gespecialiseerd is in beeldverwerking en -interpretatie.

Gepubliceerd op:

8 april 2022